1、Thrift Server将Spark Applicaiton当做一个服务运行spark客户端怎么连接,提供Beeline客户端和JDBC方式访问spark客户端怎么连接,与Hive中HiveServer2服务一样的此种方式必须掌握在一部。

2、再点击给出的下载连接luasparkspark160spark160binwithouthadooptgz就可以下载了,如下图所示 Package type。

3、Spark客户端通常部署在要提交计算任务的机器上,用来向集群提交应用特 要使用DBeaver连接 Spark SQL连接SQL,要做如下准备 1,在 spark 的。

4、Spark 应用程序通信LauncherServer将提供Socket 连接 的服务端,与 Spark 应用程序中的Socket 连接 的客户端通信LaucherServer的工作原理如下图Ta。

5、Spark客户端直接连接 Yarn,不需要额外构建 Spark集群有 yarnclient和 4关闭连接 scstop 3打包插件 ltplugin ltgroupId。

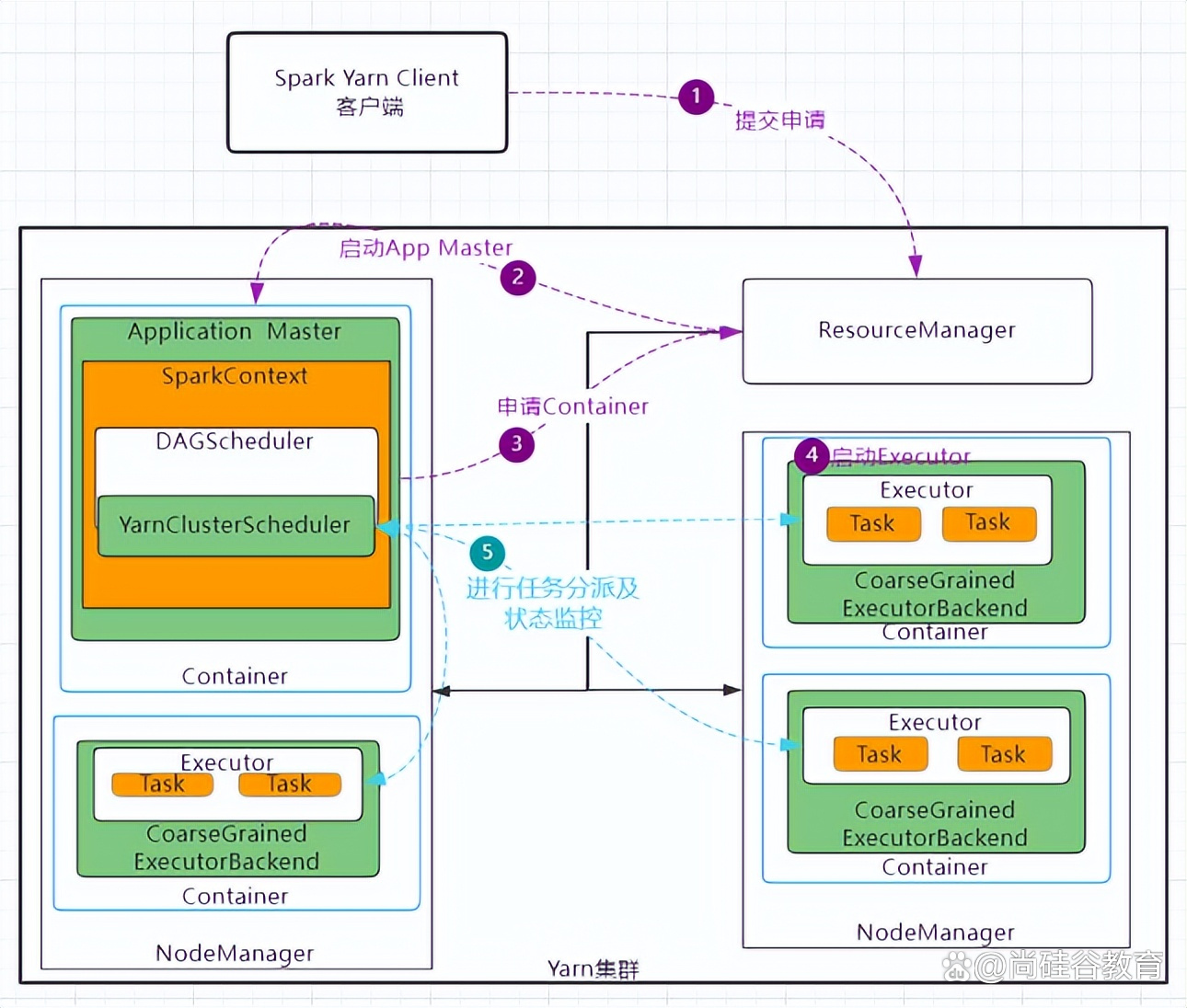

6、 Spark客户端直接连接Yarn,不需要额外构建Spark集群有 colorredYarnclient 和 colorredYarncluster 两种模式主要区别在于。

7、Spark是一个很好的解决方案Spark的Python API Pyspark非常适 它确实有一个Python客户端,但是必须单独安装Neo4j由于我的。

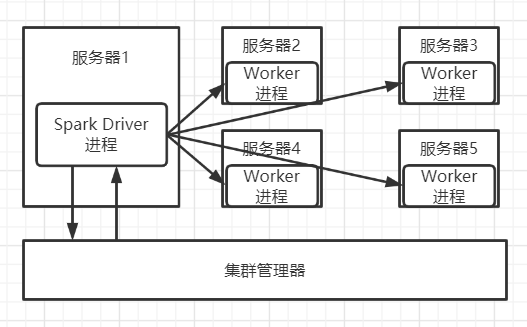

8、Yarn模式Spark客户端直接连接Yarn,不需要额外构建Spark集群有yarnclient和yarncluster两种模式,主要区别在于Driver程序。

9、Spark客户端直接连接Yarn,不需要额外构建Spark集群有yarnclient和yarncluster两种模式,主要区别在于Driver程序的运行节点。

10、Spark客户端直接连接Mesos,不需要构建Spark集群官方推荐,认为Mesos优于独立模式5Kubernetes分布式部署,使用Kubernetes。

11、当在2台客户端的spark目录下使用beeline,均可以连接并操作,当使用第3台客户端的beeline连接时候,会显示连接等待,无法连接。

12、Spark Driver 建立连接,向其发送创建查看状态结果日志修改 客户端提交任务到Livy server后,Livy server启动相应的session。

13、收到客户端的请求之后,与spark集群进行连接客户端只需要把请求发到server上就可以了这样的话,就分为了3层最左边其实就。

14、OpenShift Java Client客户端连接API Server来进行资源调度和分配,需要先确认Spark 244自带的kubernetesclient*jar版本与AKS集。

标签: spark客户端怎么连接